Robots.txt – это текстовый файл, в котором указаны рекомендации для роботов поисковых систем относительно индексации сайта. Расположен данный файл в корневом каталоге сайта и среди его основных функций мы можем выделить следующие:

- Указание главного зеркала сайта;

- Указание пути к карте сайта для роботов;

- Создание необходимых правил обхода страниц поисковым краулером.

Помимо возможности давать рекомендации поисковыми системам по индексации сайта, роботс тхт максимально удобен в редактировании. Для этого через доступ FTP файл можно открыть через любой текстовый редактор, внести необходимые правки и загрузить обновленный файл в корень сайта с заменой старого документа. При этом некоторые CMS обеспечивают возможность редактирования без необходимости скачивать файл.

Важно отметить, что директивы robots txt могут не работать даже при правильном их составлении. Зачастую это связано со следующими синтаксическими ошибками:

- Итоговый размер файла превышает максимально допустимое значение для Яндекса в 500 килобайт и Гугла в 500 кибибайт;

- В процессе создания вы использовали кодировку, которая отличается от UTF-8, что актуально именно для Google;

- Расширение файла не txt или в его названии содержатся недопустимые символы;

- К файлу по определенным причинам нет доступа на сервере.

Исходя из всех вышеперечисленных пунктов можно отметить необходимость регулярно делать анализ robots txt, проверяя его на работоспособность.

Синтаксис и директивы файла Robots.txt для сайта

Настройка robots txt для сайта предполагает создание директив, которые можно разделить на обязательные и необязательные. Размещение данных директив также должно быть в определенном порядке, что позволи краулерам поисковых систем нормально их воспринимать. Стандартно первой директивой должна быть User Agent, после следует запрет на индексацию Disallow, затем разрешение индексации Allow и окончательным этапом указывается основное зеркало сайта через директиву Host. Во избежания ошибок в процессе настройки Robots.txt мы рекомендуем обратить внимание на следующие правила работы с синтаксисом:

- В одной строке прописывается одна директива;

- Любая новая директива прописывается с новой строки;

- В начале строки и между строками не допускаются пробелы;

- Описываемый параметр нельзя переносить в новую строку;

- Перед всеми страницами сайта в директории обязательно нужно ставить слэш (/).

Важно отметить, что все директивы должны быть прописаны только латинскими символами. Правильный robots txt содержит в себе ряд директив, которые стоит рассмотреть более детально.

User-agent

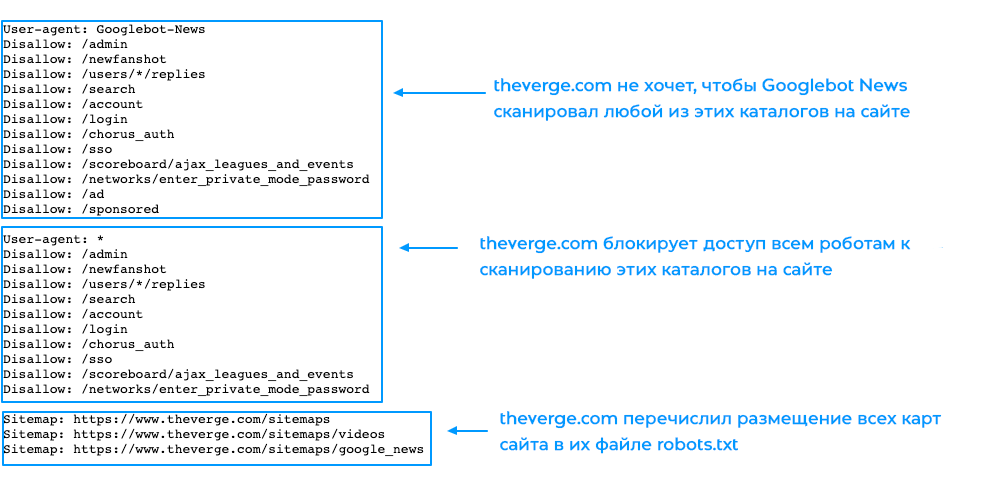

Это обязательная директива файла, которая прописывается в первой строке. Основная цель данной директивы – это обращение к поисковому роботу, соответственно, существуют следующие ее варианты:

- User-agent: *

- User-agent: Yandex

- User-agent: Googlebot

Первый вариант предполагает обращение ко всем поисковым роботам, а остальные к конкретной поисковой системе.

Disallow

Директива указывает поисковому роботу на запрет индексации конкретной части сайта. При сочетании с директивой User-agent можно обеспечить запрет индексации для всех роботов или для конкретного поискового краулера.

Allow

Директива разрешает поисковым роботам индексацию всех страниц сайта или разделов, которые включают в себя данные страницы.

Crawl-Delay

Директива позволяет задать временной период, через который робот будет индексировать страницы. При заданном параметре Crawl-delay: 5 краулер будет индексировать следующую страницу через 5 секунд.

Host

Благодаря данной директиве можно указать главное зеркало сайта с www или без www.

Sitemap

Можно указать путь к карте сайта, а сама директива выглядит следующим образом Sitemap: mysite.com/sitemap.xml.

Как сделать Robots.txt

Правильный файл robots txt можно создать вручную, используя необходимые вам вышеперечисленные директивы в зависимости от особенностей вашего сайта. Если вы не можете самостоятельно создать роботс для сайта или боитесь допустить ошибки, можно использовать один из следующих генераторов онлайн:

- PR-CY;

- Seolib;

- Media Sova.

Любой из вышеперечисленных сервисов обеспечивает автоматическую генерацию файла, поэтому проблем с тем, как как сделать robots txt для сайта у вас не возникнет. Важно отметить, что содержимое файла robots txt отличается не только в зависимости от конкретного сайта, но и в зависимости от CMS.

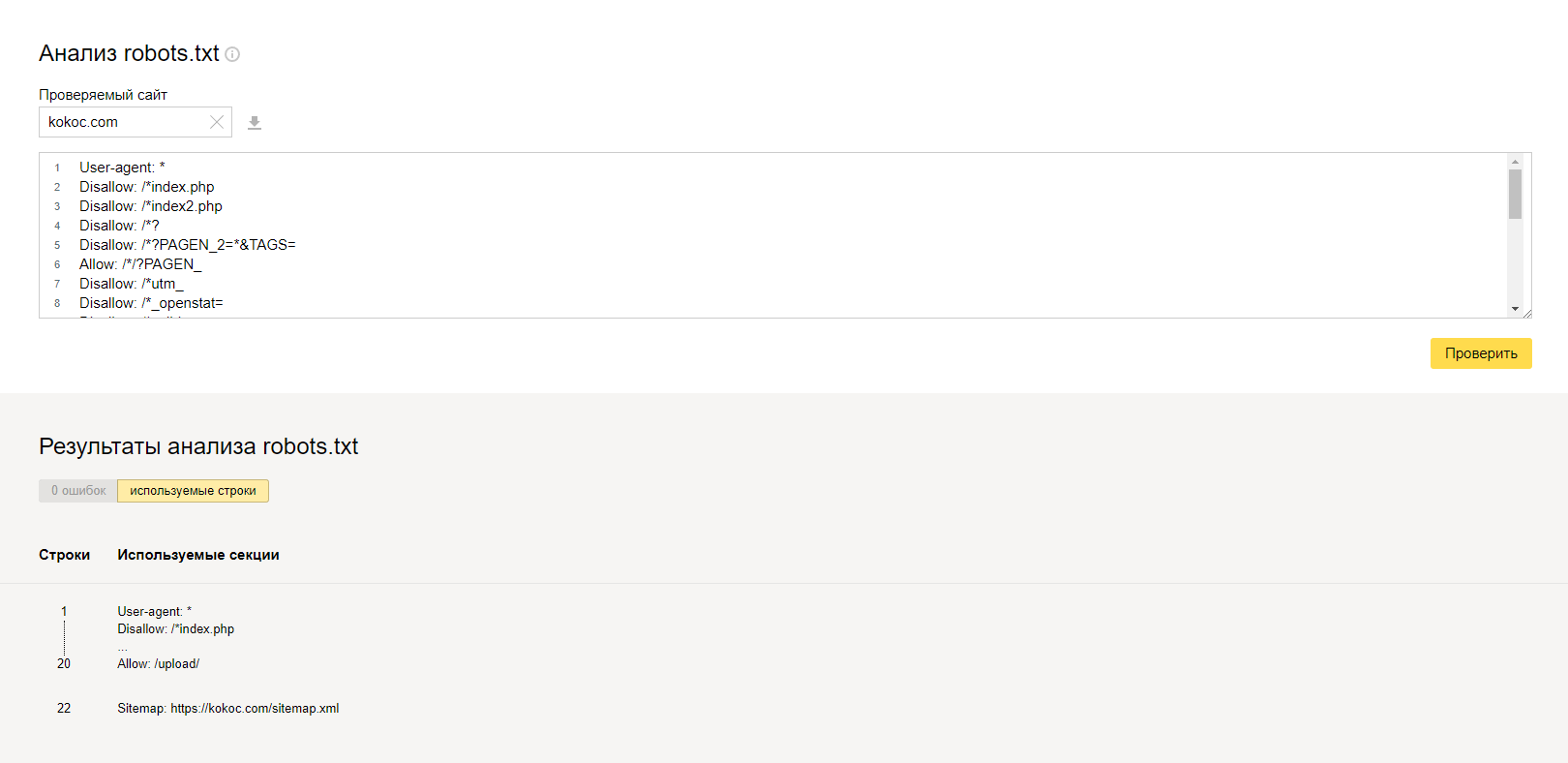

Проверка файла robots.txt

Когда мы уже рассмотрели как создать robots txt и сгенерировали текстовый файл, его необходимо проверить на работоспособность. Для этого мы рекомендуем воспользоваться одним из множества онлайн сервисов.

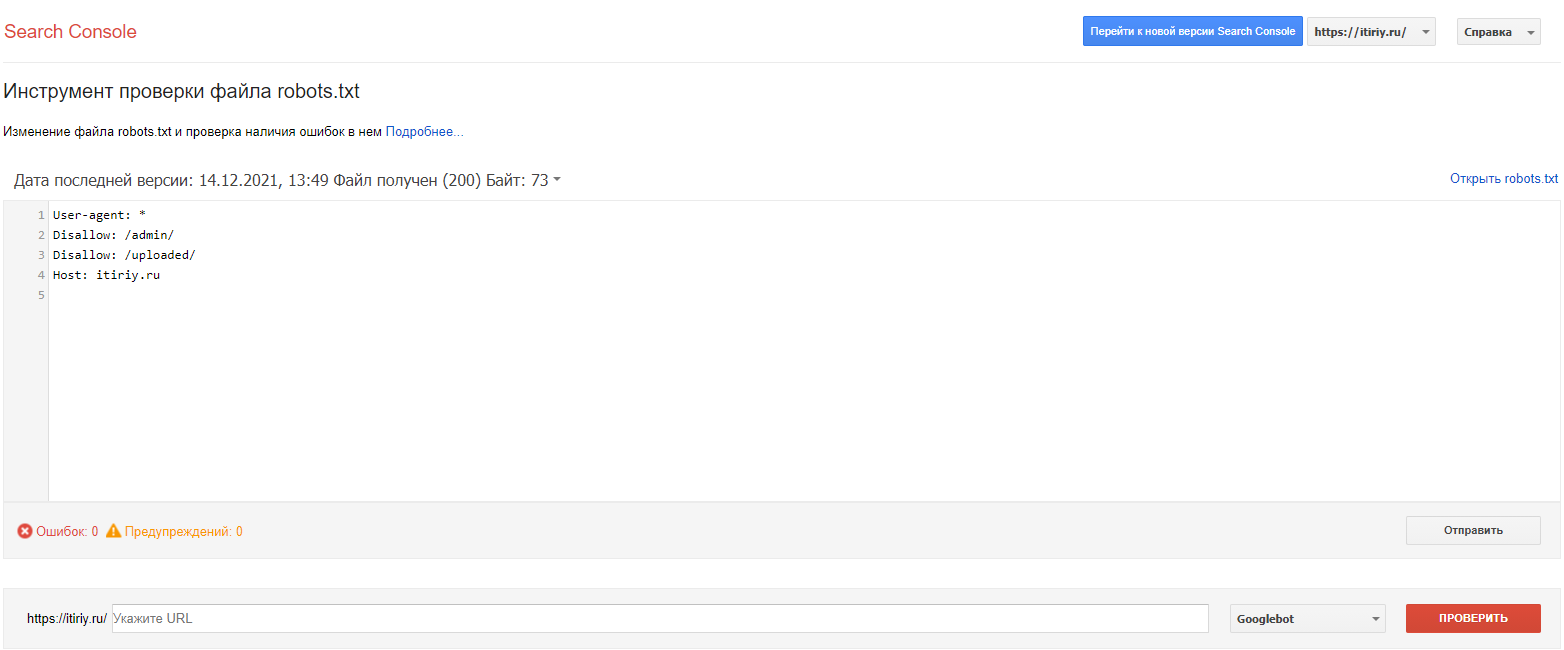

Google Search Console и Яндекс.Вебмастер

Стандартные сервисы поисковых систем, которые в своем функционале предлагают возможность проверки файла роботс на правильность и отсутствие ошибок.

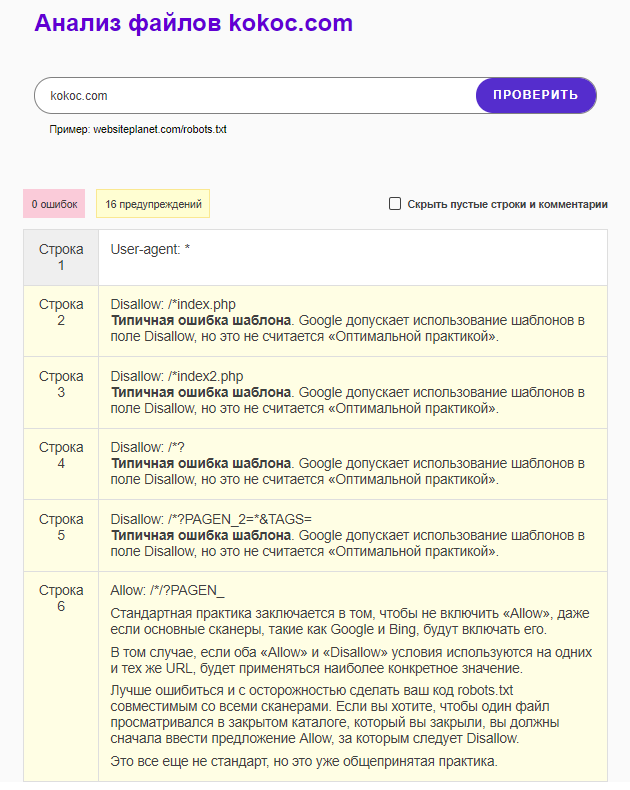

Website Planet

На главной странице сайта доступны все инструменты сервиса, среди которых есть проверка файла robots. После ввода адреса сайта мы получаем не только наличие ошибок или их отсутствие, но и любые предупреждения по файлу.

Данный сервис можно с уверенностью назвать самым информативным для анализа роботс.

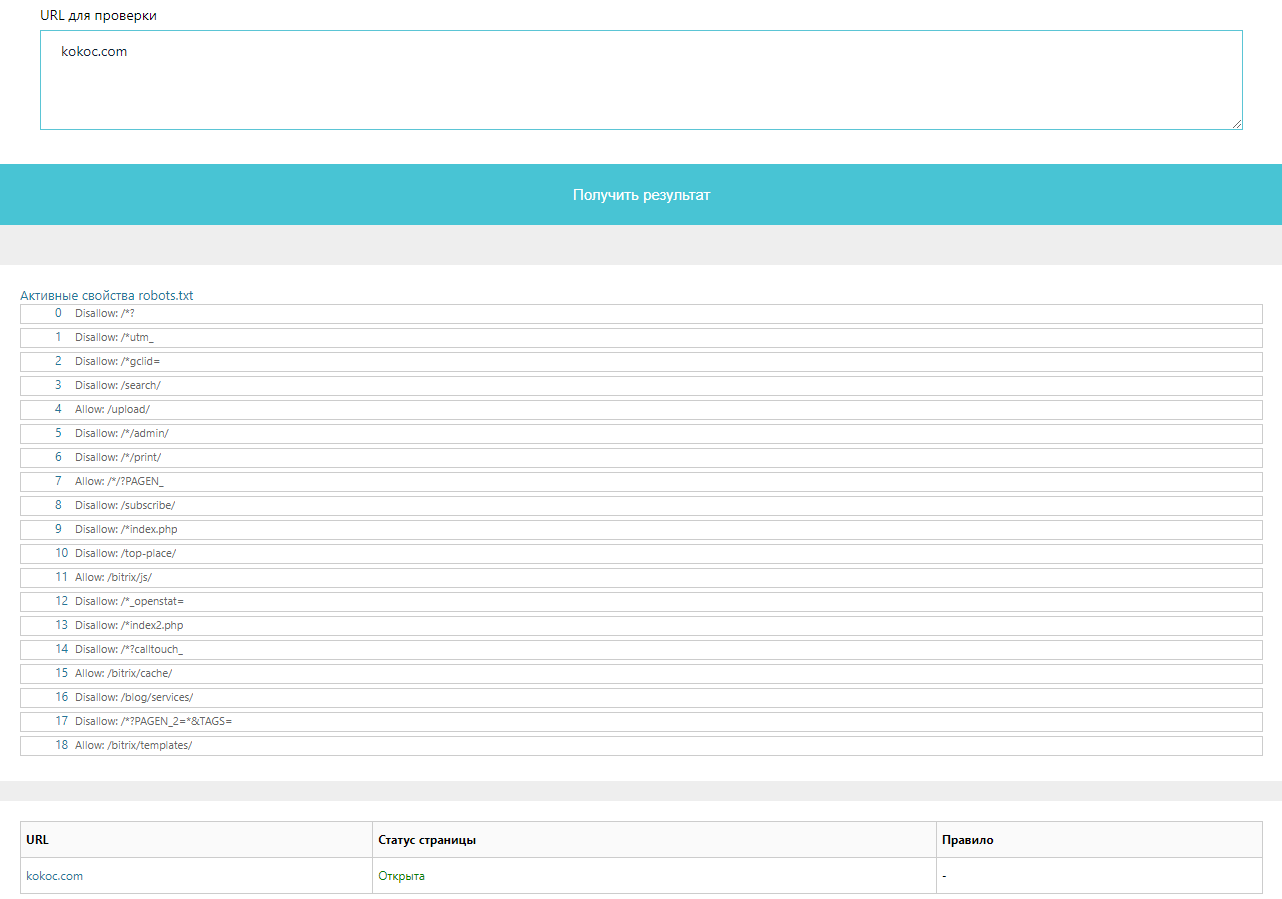

Tools.descript.ru

Проверка осуществляется стандартным методом через инструменты, которые предлагает Tools.descript. В окне для проверки просто вводим URL сайта и получаем детальный отчет.

Ключевой особенностью сервиса можно отметить возможность выбора не только целевого краулера определенной поисковой системы, но и выбор конкретной CMS. Это позволяет проверить правильность создания Robots для любого движка сайта.

Возьмем на себя все заботы по продвижению и раскрутке сайта:

> Создание сайта > SEO продвижение > Контекстная реклама в Яндекс и Google

Подпишись на рассылку, чтобы не пропустить ничего интересного!